Was Sie über KI wissen sollten – Teil 3

Hinweis: Die IT-Power Services weist darauf hin, dass dieser Blogbeitrag zu reinen Informationszwecken erstellt wurde und keinerlei Meinung unseres Unternehmens oder Einzelpersonen darstellt, wenn nicht explizit angeführt. Diese Informationen wurden nach bestem Wissen und Gewissen zusammengestellt, erheben aber keinen Anspruch auf Vollständigkeit.

Risiken

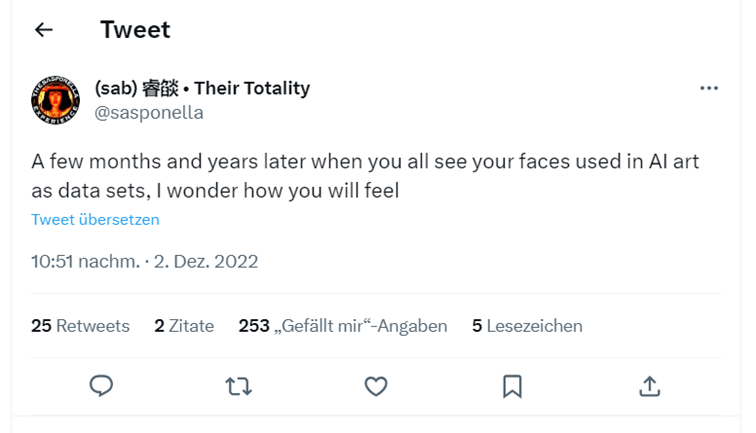

Bilderrechte und gefälschte Bilder, schön und gut, aber was ist daran jetzt gefährlich? Hier ein paar Beispiele von Experten.

Narrative Manipulation

„Ein Bild kann eine narrative Wirkung haben“. Das erklären die amerikanische Soziologin, Catherine Kohler Riessman in „Narrative Methods for the Human Sciences“ sowie die britische Philosophin Gillian Rose in „Visual Methodologies“. „Bilder sind besonders effektiv darin, Menschen oder Gruppen optisch zu Gegenspielern zu machen […] Das ist einer der Aspekte der uns am meisten beschäftigen sollte […] Dabei ist es fast zweitrangig, ob wir auf Anhieb erkennen, dass ein Bild KI-generiert ist oder auf Anhieb als Fälschung erkannt wird. Dass es einmal gesehen wurde, dass es so sein könnte, reicht oftmals für das manipulative Moment.“

Filmindustrie streikt in Hollywood und England

Die Verwendung von KI im Filmgeschäft ist ebenfalls nicht neu. Nicht anders ist es zu erklären, dass Harrison Ford mit 80 Jahren auch als „junge Version“ zu sehen ist und Tom Hanks seit Forrest Gump nicht gealtert ist. Auch James Dean soll in einem Film wieder zum Leben erwachen.

Aktuelle Regelwerke sehen vor, dass NebendarstellerInnen einen Tag lang für eine Tagesgage gescannt werden können. Die Rechte an diesen Scans würden dann an das Filmunternehmen übergehen und die Darsteller haben keinen Einfluss mehr auf die Verwendung; ohne Zustimmung. Dagegen wehren sich jetzt Schauspieler und Regisseure. Sie seien nicht grundsätzlich gegen die Verwendung von KI, aber der Umgang müsse fair geregelt werden.

Ganz nett wird das Thema in der Black-Mirror-Episode „Joan Is Awful“ thematisiert und weitergesponnen

Quellen:

ORF: Hollywood-Streik: Angst vor KI-Plänen der Filmstudios

ORF: Hollywood-Streik: Protest gegen KI auch in London

derStandard: Spart Hollywood durch künstliche Intelligenz?

Regeln der Plattformen nur bedingt hilfreich

@X (ehem. Twitter) zensiert Bilder zwar nicht, aber gibt an mit Warnhinweisen dagegen vorzugehen. TikTok will Deep Fakes über Privatpersonen vollständig verbieten. Pablo, der Papst-Bild-Erzeuger wurde auf Reddit gesperrt. Midjourney hat sein kostenfreies Angebot bereits eingestellt und in den Input-Prompts Wörter wie „arrested“ und „Xi Jinping“ verboten. Der Journalist, der die Bilder einer hypothetischen Verhaftung von Donald Trump erzeugt und verbreitet hatte, wurde von Midjourney verbannt.

Solange die Beiträge öffentlich sind, kann dagegen vorgegangen werden. Bei Whats-App, geschlossenen Facebookgruppen und Telegram ist es jedoch nicht mehr so leicht Einfluss zu nehmen.

Voraussagen anhand von geografischen Daten

In Chicago gibt es lt MAITHINK X bereits das „predictive policing program“. Das System wurde entwickelt, um vorauszusagen wie wahrscheinlich es ist in ein Verbrechen verwickelt zu werden. Dazu werden demografische Daten wie Wohnort, Hautfarbe, etc. statistisch verglichen und Korrelationen analysiert.

Auch die Schufa in Deutschland verwendet bereits Algorithmen um die Zahlungsfähigkeit zu bewerten. Damit entscheidet die KI mit, ob man in ein Haus mit Garten in der Vorstadt ziehen kann oder nicht.

Bei vielen großen Unternehmen, wie z.B. BMW und SAP werden Bewerbungen durch KI vorgefiltert. Die statistischen Daten der Frauenqoten, die dabei mitberücksichtigt werden, kann ein Algorithmus vermutlich nicht ganz fair beurteilen.

Diskriminierung

Die App "Lensa"

Mithilfe der App Lensa kann man eigene Selfies mittels KI manipulieren. Die Software verwendet Stable Diffusion (und somit LAION-5B, die auf Bildersuche im Internet basiert – wir erinnern uns). Für USD 7,99 kann man 50 Bilder von sich selbst umwandeln lassen.

Sensibel wird es dann, wenn man Bilder hochlädt die jemanden von der Schulter aufwärts zeigen, und Lensa Bilder mit übertriebenem Dekolletés und schmaler Taille zurückgibt. Also Bilder, die mit der Realität nichts zu tun haben. UserInnen gaben an, dass ihre Ergebnisse sexualisiert und mit übertriebenen Gesichtszügen dargestellt wurden. Dunkelhäutige Frauen erzählen, dass ihre Haut sogar aufgehellt und ihre Gesichtszüge anglisiert worden wären. Die Autorin Olivia Snow konnte außerdem auf Basis von Fotos aus ihrer Kindheit Nacktbilder erstellen.

Stigmatisierung

Die Twitter-Userin „Supercomposite“ aus Schweden hat aus Interesse mit KI-generierten Bildern experimentiert. Die erste Anforderung war ein Bild zu erstellen, dass so wenig wie möglich mit dem Schauspieler Marlon Brando zu tun hat. Das Ergebnis war ein Logo auf dem man eine Burg sah und den Schriftzug „Digita Pntics“.

Dann wollte sie den Umkehrschluss versuchen und bat das System das Gegenteil von diesem Bild zu zeichnen, mit der Erwartungshaltung Marlon Brandon zu sehen. Aber das Experiment schlug fehl: Sie beschrieb das Ergebnis als „am Boden zerstört aussehende ältere Frau mit ausgeprägten Dreiecken von Rosazea (?) auf den Wangen. Im Hintergrund ein heruntergekommener Wohnbereich“. Sie vermutete, dass diese Ergebnisse auf Horrorfilmbildern basierten.

Das missfiel einigen UserInnen, die ihr Diskriminierung von an der Hautkrankheit Rosazea leidenden Menschen vorwarfen.

„Supercomposite“ entgegnete, dass sie “Loab”, wie sie die Frau nannte, „lediglich entdeckt habe. Wenn KI Behinderungen und Hautkrankheiten als Horror stigmatisiert, dann ist das eine soziale Verzerrung in den Daten, die das Modell aufgreift.“

"ML Algorithmen sind Meinungen, verpackt in Mathematik"

Dieses Zitat stammt von Cathy O’Neil, einer amerikanischen Mathematikerin.

Logische Schlussfolgerung der IT-PS Redaktion: Wenn Algorithmen aus bestehenden Daten aus dem Internet lernen, dann ist der Ursprung die Information, die wir im Internet selbst erstellen. Die Informationsflut im Internet ist selbst noch nicht sehr gut geregelt und steckt noch in den Kinderschuhen. Und bedeutet leider auch, dass KI nur unseren Input verwertet… [Schlussfolgerung der IT-PS Redaktion Ende]

Lesen Sie weiter in Teil 4: Geforderte Maßnahmen & Expertenmeinungen

ThisIsEngineering by pexels

ThisIsEngineering by pexels ThisIsEngineering by pexels

ThisIsEngineering by pexels